Mit Daten sprechen? Kein Problem für den InfoTwin AI Assistant

von Marlene Groß

Apr. 29, 2025

Mit Daten sprechen? Kein Problem für den AI-Assistant • Grafik: plusmeta, Viktoria Kurpas/Shutterstock.com

Die digitale Transformation schreitet voran und mit ihr verändern sich die Anforderungen an die Technische Dokumentation. Niemand hat heute Zeit, sich durch seitenlange PDFs oder komplizierte Webseiten zu kämpfen. Nutzer erwarten schnelle, interaktive und zielgerichtete Antworten auf ihre Fragen. Hier kommt Künstliche Intelligenz (KI) ins Spiel: Sie ermöglicht eine neue, dynamische Form der Informationsbereitstellung.

In diesem Beitrag beleuchten wir, wie Large Language Models (LLMs, deutsch: große Sprachmodelle) die Bereitstellung von Anwenderdokumentationen revolutionieren und welche Vorteile sie für Nutzer und Unternehmen bieten.

Large Language Models: Neue Chancen für die Technische Dokumentation

Large Language Models sind leistungsstarke KI-Systeme, die darauf ausgelegt sind, menschliche Sprache zu verstehen und zu generieren. Sie analysieren und verarbeiten große Textmengen, extrahieren relevante Informationen und erstellen auf dieser Basis kohärente, kontextbezogene Antworten. Damit ermöglichen sie eine natürliche Sprachverarbeitung, die nicht nur Erkenntnisse liefern, sondern auch die Erstellung und Bereitstellung von Inhalten deutlich effizienter machen kann. Ein bekanntes Beispiel für einen LLM-Chatbot ist ChatGPT von Open AI.

Gerade im Bereich der Technischen Dokumentation eröffnen LLMs damit neue Perspektiven. Klassische Dokumentationsformate stoßen schnell an ihre Grenzen, vor allem, wenn Nutzer schnelle, verständliche Antworten erwarten. Chatbots auf Basis von LLMs schaffen Abhilfe: Sie beantworten Fragen in natürlicher Sprache, passen Inhalte individuell an und können sogar Übersetzungen in Echtzeit liefern. Unternehmen setzen bereits heute Chatbots im Kundenservice ein, um Anfragen effizienter zu bearbeiten – warum also nicht auch in der technischen Dokumentation?

Chatbots in der Technischen Dokumentation • Grafik: plusmeta, Viktoria Kurpas/Shutterstock.com

Vorteile im Überblick:

- Direkte Kommunikation: Anwender können ihre Fragen in natürlicher Sprache stellen und erhalten präzise und verständliche Antworten ohne sich durch umfangreiche Dokumentationen zu quälen.

- Verfügbarkeit: KI-gestützte Systeme sind rund um die Uhr einsatzbereit, reagieren in Sekunden und können unbegrenzt viele Anfragen gleichzeitig bearbeiten.

- Sprachbarrieren überwinden: KI-basierte Chatbots können Inhalte automatisch in verschiedene Sprachen übersetzen, wodurch Sprachbarrieren der Vergangenheit angehören.

- Effizienzsteigerung: Unternehmen sparen Zeit und Kosten im Vergleich zu klassischen Support-Teams und entlasten ihre Mitarbeiter, die sich auf komplexere Aufgaben konzentrieren können.

RAG: Unternehmenswissen clever integriert

Obwohl der Einsatz von KI enorme Vorteile in der Bereitstellung von Informationen bietet, gibt es auch Herausforderungen. Eine der größten ist, dass LLMs nicht über spezifisches Unternehmenswissen verfügen, das benötigt wird, um Fragen zu technischen Inhalten beantworten zu können. LLMs werden in der Regel mit großen Mengen an allgemeinen Daten trainiert werden, die nicht immer relevant oder präzise für die spezifischen Produkte oder Dienstleistungen eines Unternehmens sind.

Ein möglicher Ansatz zur Lösung dieses Problems ist das Fine-Tuning der Modelle mit firmenspezifischen Daten. Dieser Prozess ist jedoch in der Regel aufwendig und kostspielig. Ein weiteres Risiko besteht darin, dass die Daten, mit denen der KI-Chatbot nachtrainiert wurde, ungenau oder evtl. bereits veraltet sind.

Die Lösung: Retrieval-Augmented Generation (RAG)

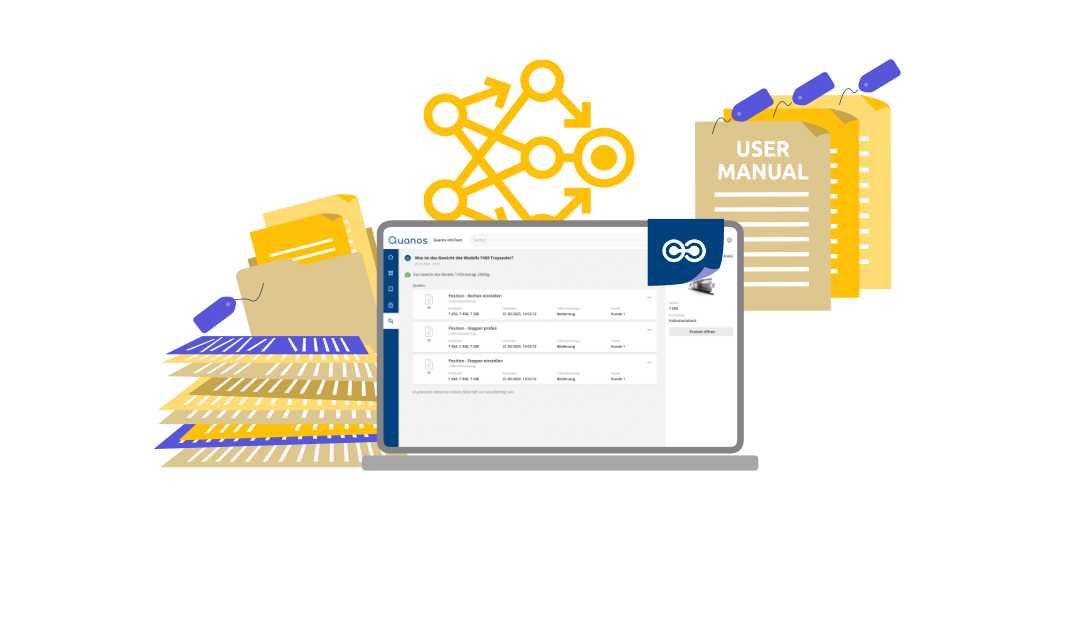

Auf Deutsch lässt sich der Begriff etwa mit „erweitertes Generieren durch Einbeziehung von Informationen“ übersetzen. Das Wissen zur Beantwortung einer Anfrage stammt dabei nicht mehr ausschließlich aus dem Sprachmodell selbst, sondern wird aus angebundenen, vertrauenswürdigen Quellen in Echtzeit abgerufen. Die Aufgabe des LLM besteht dabei vor allem darin, die gefundenen Inhalte passend zur Nutzeranfrage aufzubereiten und verständlich darzustellen.

Der Vorteil: Mit dieser Architektur lassen sich Large Language Models gezielt mit aktuellen und autorisierten Unternehmensinformationen verknüpfen, ohne das zugrunde liegende Modell verändern zu müssen. RAG bietet somit eine praxisnahe und skalierbare Lösung, um LLMs mit unternehmensspezifischem Wissen anzureichern.

Der Quanos AI-Assistant: Intelligente Unterstützung für die technische Dokumentation

INfoTwin AI Assistant • Grafik: plusmeta, Quanos

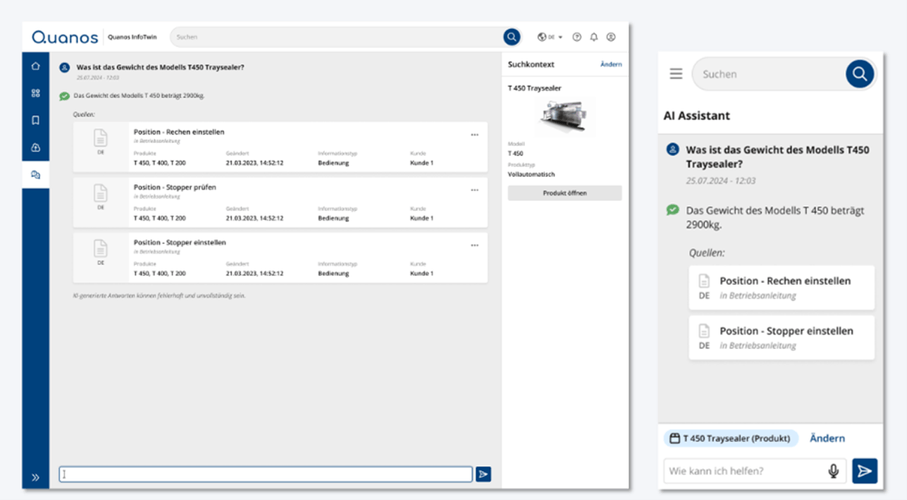

Genau hier setzt der InfoTwin AI Assistant von Quanos und plusmeta an: Er macht Ihre technischen Informationen direkt nutzbar, per intuitivem Chat-Interface, direkt im InfoTwin. Statt zu suchen, fragen Sie einfach.

Wie funktioniert der AI Assistant? Stellen Sie Ihre Fragen über das Chat-Interface und die KI greift tief in die Schatzkiste des Quanos InfoTwin-Wissensmodells, um kontextbezogene und präzise Antworten zu liefern.

Wie zuverlässig ist die Lösung? Der Chatbot basiert auf der bereits vorgestellten RAG-Architektur (Mehr dazu in diesem Blogbeitrag) – er verwendet nur im InfoTwin hinterlegte Daten, um Fehlinterpretationen und „Halluzinationen“ zu vermeiden.

Der AI Assistant im Quanos InfoTwin • Grafik: plusmeta, Quanos

Vorteile des InfoTwin AI Assistant:

Der AI Assistant von Quanos setzt neue Maßstäbe in der Interaktion mit technischen Dokumentationen. Als leistungsstarke Erweiterung des Quanos InfoTwins ermöglicht er eine schnelle, präzise und benutzerfreundliche Beantwortung von Fragen – direkt aus den hinterlegten Daten.

- Nahtlose Integration: Der Assistant ist direkt im InfoTwin eingebettet und bietet ein intuitives Chat-Interface. So kommunizieren Sie mühelos mit Ihren Daten – genau dort, wo Sie sie brauchen.

- Einfache Handhabung: Langes Suchen gehört der Vergangenheit an: Statt sich durch komplexe Dokumentationen zu arbeiten, stellen Sie einfach Ihre Frage – der AI Assistant liefert Ihnen sofort die passende Antwort, abgestimmt auf Ihre Produkte und Assets.

- Verlässliche Genauigkeit: Alle Antworten basieren ausschließlich auf verifizierten Daten innerhalb Ihres InfoTwins. So erhalten Sie fundierte Informationen – zuverlässig und präzise.

Neugierig geworden?

Der InfoTwin AI Assistant befindet sich derzeit in der Pilotphase. Gemeinsam mit ausgewählten Kunden testen wir bereits die vielfältigen Einsatzmöglichkeiten in der Praxis. Möchten auch Sie Teil dieser spannenden Phase sein? Dann nehmen Sie noch heute Kontakt zu uns auf und vereinbaren einen unverbindlichen Demotermin mit uns. Überzeugen Sie sich selbst von den vielfältigen Einsatzmöglichkeiten des InfoTwin AI Assistants und erleben Sie, wie KI die Bereitstellung von technischen Informationen revolutioniert.

Quellen

Fritz, Michael; Robers, Ralf (2024): KI in der Technischen Kommunikation – Herausforderung und Chancen. Whitepaper, Ausgabe 1/2024.